Experimentación de las estructuras narrativas del género documental mediante técnicas de Realidad Aumentada (AR). El usuario visualiza por la pantalla de una tablet-Pc la imagen 3D de páginas virtuales flotando en el espacio y al aproximarse a ellas escucha fragmentos de conversaciones grabadas a los vecinos del barrio del Cabanyal de Valencia.

Experimenting with narrative structures of the documentary genre through techniques of Augmented Reality (AR). The user sees through the screen of a tablet-PC 3D image of virtual pages floating in space and approach them listen to fragments of recorded conversations the neighbors from El Cabanyal of Valencia.

Proyecto realizado junto al laboratorio de Investigación MEDICLAB de la U.P.V.

Notbook es una instalación artística basada en un dispositivo multiusuario de narración multimedia, realizada utilizando tecnología de realidad aumentada (AR). Propone al espectador explorar los caminos que forman distintas lecturas interrelacionadas, jugando con las diversas pistas que le ofrecen las imágenes 3D y el sonido.

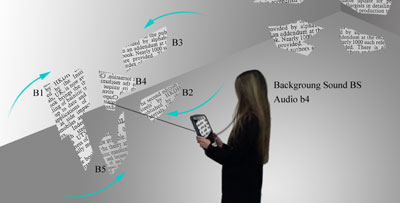

La instalación se desarrolla en un espacio cuadrangular vacío, donde los usuarios se sitúan llevando en sus manos dos tablet PC equipadas, cada una de ellas, con: webCam USB2, sensor inercial y auriculares.

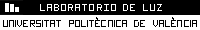

Por la tecnología de Realidad Aumentada el espectador verá, en el monitor de la Tablet PC, imágenes 3D sobre la propia imagen del espacio y de los otros espectadores que allí se encuentren. Esas imágenes recrean el despliegue de fragmentos de páginas sueltas y flotantes que se mueven sutilmente en el espacio, desligadas del orden que le impondría el libro. El mapeado de los fragmentos de página hace referencia gráficamente a los propios textos que se escuchan.

El audio es la lectura de tres textos relacionados con el barrio del Cabanyal de Valencia. En el espacio de la sala se articulan tres zonas de audio que están relacionadas con los objetos 3D de la simulación. Uno de los audios nos cuenta la repercusión sobre el entorno natural de los cambios ocurridos en el barrio desde su asentamiento. El segundo narra los cambios económicos de la zona tomando el puerto como motor de cambio para el barrio. Por último la tercera zona de audio cuenta la relación de las personas que habitan el barrio incidiendo en la memoria individual y colectiva de los vecinos.

ELEMENTOS

El entorno de Realidad Aumentada al que accede el espectador con su recorrido, está compuesto de diferentes tipos de elementos que por su naturaleza propician el carácter multisensorial del proyecto: imagen 3D y sonido. Todos ellos están organizados según tres bloques temporales:

A: Pasado.

B: Presente.

C: Futuro.

El entorno 3D está compuesto por 15 modelos que representan fragmentos de páginas y están agrupados de cinco en cinco:

A1-A2-A3-A4- A5 a fragmentos de páginas relacionados con narraciones del pasado,

B1-B2-B3-B4-B5 a fragmentos de páginas relacionados con narraciones del presente

C1-C2-C3-C4-C5 a fragmentos de páginas relacionados con expectativas de futuro

Por último, hay 1 sonido de viento que anuncia el cambio de posición de las páginas de forma aleatoria, modificando la situación desde la que se escuchan las narraciones.

INTERACTIVIDAD

En el entorno 3D de Realidad Aumentada se encuentran distribuidos los modelos de las 15 fragmentos de páginas. En cada una de ellos puede leerse parte de un texto relacionado con una de las 15 narraciones sonoras. Gráficamente, estos modelos son elementos planos de forma irregular con un mallado editable al que se le pueden asignar determinados movimientos. La totalidad de los fragmentos se encuentran como flotando por el espacio configurando un entorno circular.

El usuario puede moverse por el espacio y visualizar esos fragmentos en el monitor de la tablet-PC, de tal manera que, al encuadrar fijamente uno de ellos «conecta» con él y lo activa, entonces se produce un doble evento: se activa el archivo de audio vinculado a ese modelo y el grupo de fragmentos de hojas al que pertenece el fragmento seleccionado se reagrupa espacialmente, girando alrededor de éste, el cual permanece fijo en el centro.

Por ejemplo, si el usuario selecciona el fragmento B4, en ese instante los fragmentos B1-B2-B3-B5 se aproximan, mediante un movimiento giratorio. Si continúa andando hacia otra posición, el audio de la narración b4 se desvanece, si «conecta» con los fragmentos de página contiguos empezará a entrar por fundido su audio correspondiente.

Pero, ¿qué sucede mientras el usuario no conecta con ningún fragmento de hoja? Si se aleja de la zona de influencia de ese tema, seguirá escuchando el sonido de fondo cada vez más bajo. Si entra en otra zona volverá a escuchar suavemente ese sonido de fondo, incrementándose cuando se acerque a una posición próxima a algún fragmento de página.

Cuando los usuarios se miren de frente, se generan dos nuevos modelos planos mapeados con un vídeo y situados paralelos a las Tablet PC y a poca distancia, de manera que en los monitores aparece la imagen parcial del narrador que alternativamente mira a uno y otro, aportándoles pistas y comentarios sobre los fragmentos que estaban oyendo.

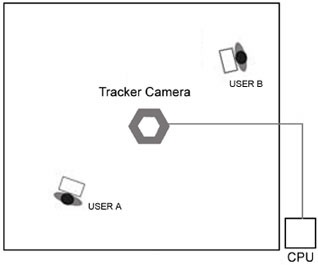

Un tercer ordenador central calcula la posición en la sala de las dos TabletPC mediante un sistema de visión por ordenador compuesto por una cámara colocada en el techo de la sala. Esta CPU central envía por red inalámbrica a cada TabletPC los datos de su posición. A estos datos se unen los parámetros de orientación del sensor que lleva cada usuario, obteniendo así los parámetros necesarios para renderizar los objetos 3D en la posición y orientación del monitor-cámara a tiempo real. Estos mismos datos son los que necesita el sistema para detectar que las dos tablets se han situado una frente a otra y activar la aparición del vídeo con la imagen del narrador.

Participantes

Presentado en

ACE 2005, Sala de Exposiciones, Universidad Politécnica de Valencia

Subvencionado por

Proyecto I+D+I Sistema multiusuario de manipulación de imagen en movimiento en un entorno 3d por medio de una interface gestual (Ref. PPI05-03-4276, 2003)